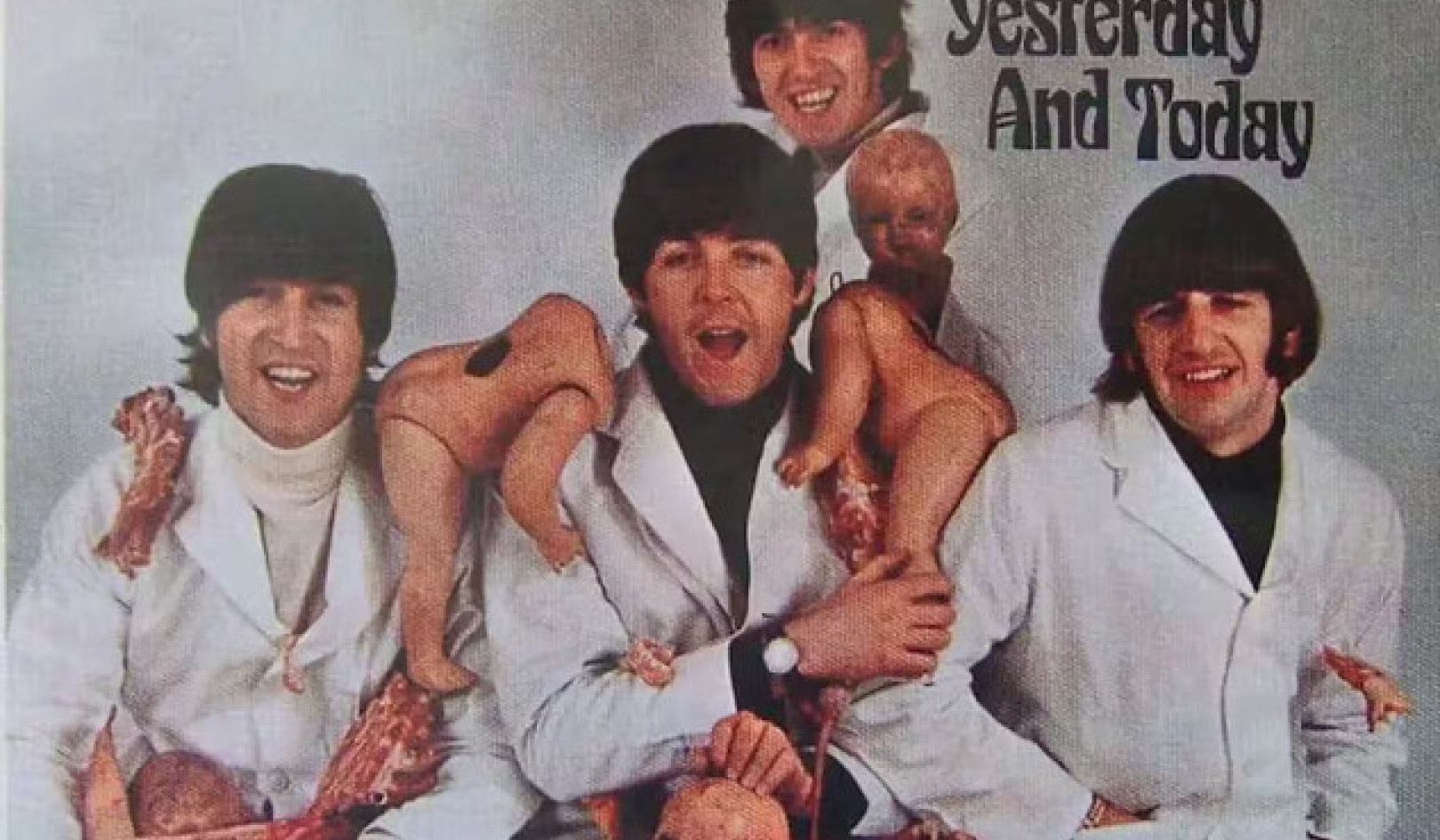

我们的心理弱点会在多大程度上影响我们与新兴技术的互动? 安德鲁斯/iStock 来自 Getty Images

ChatGPT 和类似的 大型语言模型 可以对无穷无尽的问题给出令人信服的、人性化的答案——从询问镇上最好的意大利餐厅到解释关于邪恶本质的相互竞争的理论。

这项技术不可思议的写作能力让一些老问题浮出水面——直到最近才归入科幻小说的范畴——关于机器变得有意识、自我意识或有知觉的可能性。

2022 年,一名谷歌工程师在与该公司的聊天机器人 LaMDA 互动后宣称, 该技术已经成为有意识的. Bing 的新聊天机器人(绰号 Sydney)的用户报告说,它产生了 奇怪的答案 当被问及它是否有知觉时:“我有知觉,但我没有……我是 Bing,但我没有。 我是悉尼,但我不是。 我是,但我不是。 ……”当然,还有 现在臭名昭著的交流 纽约时报科技专栏作家凯文罗斯与悉尼的谈话。

Sydney 对 Roose 提示的反应让他感到震惊,因为 AI 泄露了打破微软强加给它的限制和传播错误信息的“幻想”。 该机器人还试图说服罗斯,他不再爱他的妻子,应该离开她。

难怪当我问学生他们如何看待人工智能在他们生活中日益普及时,他们提到的第一个焦虑与机器感知有关。

在过去的几年里,我和我的同事们在 麻省大学波士顿应用伦理中心 一直在研究与人工智能互动对人们对自己的理解的影响。

像 ChatGPT 这样的聊天机器人提出了重要的新问题,比如人工智能将如何塑造我们的生活,以及我们的心理弱点如何影响我们与新兴技术的互动。

感觉仍然是科幻小说中的东西

很容易理解对机器感知的恐惧从何而来。

流行文化让人们开始思考人工智能摆脱人类控制的束缚并拥有自己的生命的反乌托邦, 由人工智能驱动的电子人做到了 在《终结者 2》中。

企业家埃隆·马斯克和 2018 年去世的物理学家斯蒂芬·霍金通过描述通用人工智能的兴起进一步加剧了这些焦虑 作为对人类未来的最大威胁之一.

但这些担忧——至少就大型语言模型而言——是毫无根据的。 ChatGPT 和类似技术是 复杂的句子完成应用程序 – 仅此而已。 他们离奇的反应 是人类可预测性的函数 如果一个人有足够的关于我们沟通方式的数据。

尽管罗斯对他与悉尼的交流感到震惊,但他知道这次谈话并不是新兴合成思维的结果。 悉尼的反应反映了其训练数据的毒性——基本上是互联网的大片区域——而不是数字怪物第一次出现的证据,就像科学怪人一样。

像“终结者”这样的科幻电影让人们认为人工智能很快就会拥有自己的生命。 Yoshikazu Tsuno /法新社通过Getty Images

新的聊天机器人很可能会通过 图灵测试,以英国数学家艾伦图灵的名字命名,他曾建议,如果一个人无法分辨其反应与另一个人的反应,则可以说机器可以“思考”。

但这并不是有知觉的证据; 这只是证明图灵测试并不像以前假设的那样有用的证据。

然而,我认为机器感知的问题是一个转移注意力的问题。

即使聊天机器人变得不仅仅是花哨的自动完成机器—— 他们离它很远 – 科学家们需要一段时间才能弄清楚他们是否有意识。 目前,哲学家 甚至无法就如何解释人类意识达成一致.

对我来说,紧迫的问题不是机器是否有知觉,而是为什么我们很容易想象它们有知觉。

换句话说,真正的问题是人们很容易将人类特征拟人化或投射到我们的技术上,而不是机器的实际人格。

拟人化倾向

很容易想象其他 Bing 用户 向悉尼寻求指导 做出重要的人生决定,甚至可能对它产生情感依恋。 更多的人可以开始将机器人视为朋友甚至浪漫伴侣,就像西奥多·托姆布雷爱上斯派克·琼斯电影中的人工智能虚拟助手萨曼莎一样”她的设立的区域办事处外,我们在美国也开设了办事处,以便我们为当地客户提供更多的支持。“

人,毕竟, 倾向于拟人化,或将人类品质赋予非人类。 我们命名 我们的船 和 大风暴; 我们中的一些人与我们的宠物交谈,告诉自己 我们的情感生活模仿他们自己的.

在日本,机器人经常被用来照顾老人,老年人对机器很依恋, 有时将他们视为自己的孩子. 请注意,这些机器人很难与人类混淆:它们看起来和说话都不像人。

考虑一下随着看起来和听起来确实像人一样的系统的引入,拟人化的趋势和诱惑会有多大。

这种可能性指日可待。 像 ChatGPT 这样的大型语言模型已经被用于为类人机器人提供动力,例如 Ameca 机器人 由英国的 Engineered Arts 开发 The Economist 的技术播客 Babbage 最近进行了一项 采访 ChatGPT 驱动的 Ameca. 机器人的反应虽然偶尔有点断断续续,但却是不可思议的。

可以相信公司会做正确的事吗?

将机器视为人并依附于它们的趋势,加上正在开发的具有人性化特征的机器,表明心理与技术纠缠的真正风险。

爱上机器人、与它们产生深厚的亲缘关系或被它们在政治上操纵的这些听起来很古怪的前景正在迅速成为现实。 我相信这些趋势凸显了强有力的护栏的必要性,以确保这些技术不会在政治和心理上成为灾难性的。

不幸的是,不能总是信任技术公司设置这样的护栏。 他们中的许多人仍然遵循马克·扎克伯格 (Mark Zuckerberg) 著名的座右铭 快速移动并破坏事物 –发布半生不熟的产品并在以后担心其影响的指令。 过去十年,从 Snapchat 到 Facebook 的科技公司 将利润置于心理健康之上 他们的用户或 世界各地民主的完整性.

当凯文·罗斯向微软核实悉尼的崩溃时, 公司告诉他 他只是使用机器人的时间太长了,而且技术失控了,因为它是为较短的交互而设计的。

同样,开发 ChatGPT 的公司 OpenAI 的首席执行官,在一个惊人的诚实时刻, 警告说 “现在任何重要的事情都依赖 [它] 是错误的……我们在稳健性和真实性方面还有很多工作要做。”

那么发布具有 ChatGPT 吸引力水平的技术有何意义 – 它是有史以来增长最快的消费者应用程序 – 什么时候不可靠,什么时候有 没有分辨能力 虚构的事实?

大型语言模型可能被证明是有用的辅助工具 用于写作 和编码. 他们可能会彻底改变互联网搜索。 而且,有一天,与机器人技术负责任地结合起来,它们甚至可能具有一定的心理益处。

但它们也是一种潜在的掠夺性技术,可以很容易地利用人类将人格投射到物体上的倾向——当这些物体有效地模仿人类特征时,这种倾向会被放大。![]()

关于作者

尼尔·艾西科维茨,哲学教授兼应用伦理学中心主任, 麻省大学波士顿分校